"计算机能够看到, 听到和学习。欢迎来到未来。"

机器学习是未来。根据福布斯, 机器学习专利在2013年至2017年之间以34%的速度增长, 并且在未来的一段时间里只会增长。此外, 哈佛商业评论文章称数据科学家为" 21世纪最勤奋的工作"(这就是刺激因素!!!)。

在这些高度动态的时代, 开发了各种机器学习算法来解决复杂的现实世界问题。这些算法是高度自动化和可自我修改的, 因为它们会随着时间的推移不断改进, 增加了更多的数据量, 并且所需的人工干预最少。因此, 本文涉及十大机器学习算法.

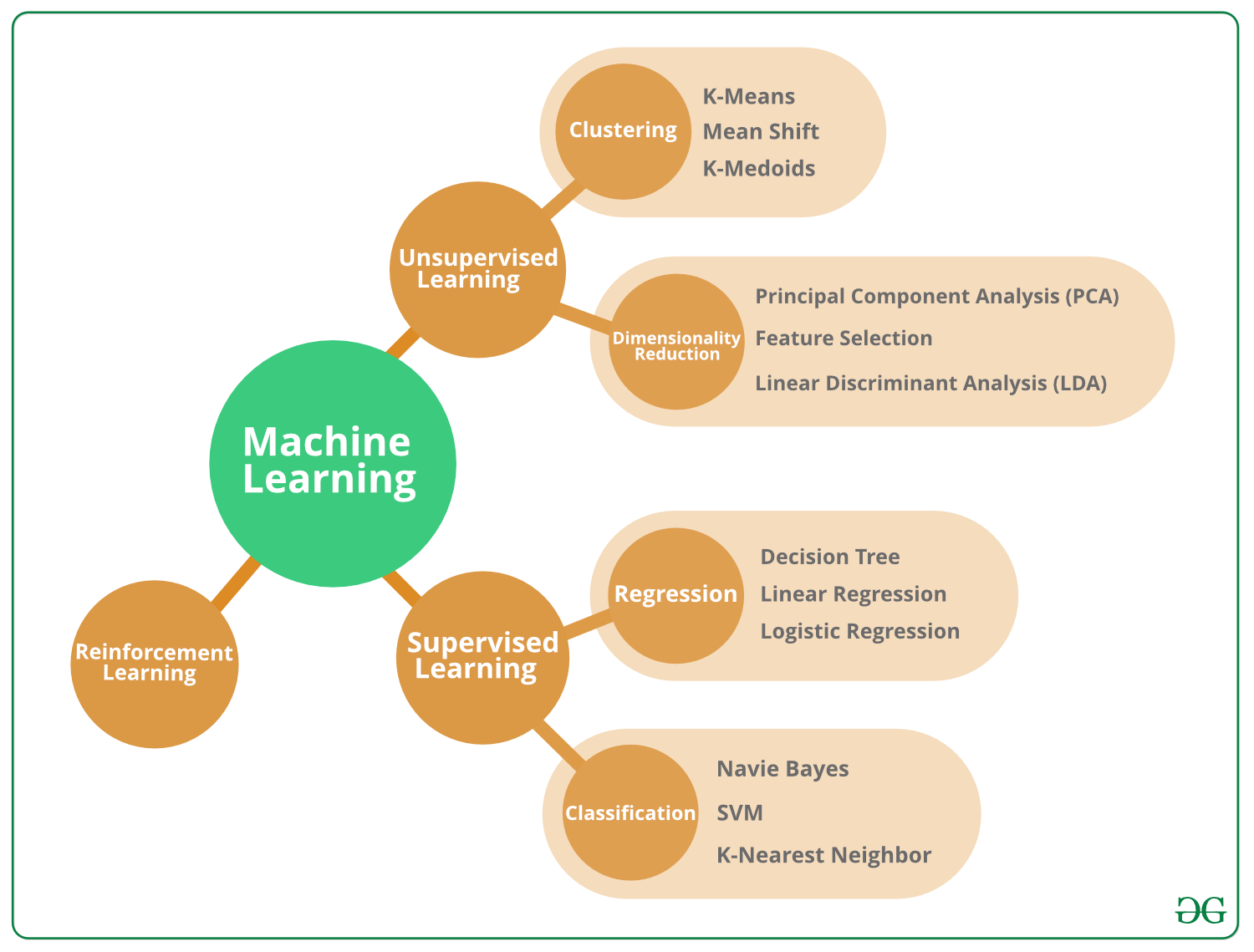

但是要了解这些算法, 首先, 简要说明它们可以属于的不同类型。

机器学习算法的类型–

机器学习算法可以分为3种不同的类型, 即:

监督机器学习算法:

想象一个老师指导一个班级。老师已经知道了正确的答案, 但是学习过程要到学生也学习了答案(可怜的孩子们!)后才会停止。这是监督机器学习算法的本质。在这里, 该算法是从训练数据集中学习并做出教师纠正的预测的学生。这种学习过程一直持续到算法达到要求的性能水平为止。

无监督机器学习算法:

在这种情况下, 班上没有老师, 可怜的学生只能自己学习!这意味着对于无监督机器学习算法, 没有特定的答案需要学习, 也没有老师。该算法不受监督, 无法找到数据中的底层结构, 从而越来越多地了解数据本身。

强化机器学习算法:

好吧, 这里假设的学生会随着时间的流逝从自己的错误中学习(就像生活!)。因此, 强化机器学习算法通过反复试验来学习最佳动作。这意味着该算法通过学习基于其当前状态的行为来决定下一个动作, 该行为将在将来最大化回报。

顶级机器学习算法

已经开发了特定的机器学习算法来处理复杂的实际数据问题。因此, 现在我们已经了解了机器学习算法的类型, 下面让我们研究数据科学家已经存在并实际使用的顶级机器学习算法。

1.朴素贝叶斯分类器算法–

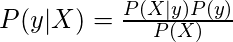

如果你必须手动对诸如网页, 文档或电子邮件之类的数据文本进行分类, 将会怎样?好吧, 你会生气!但值得庆幸的是, 该任务是由朴素贝叶斯分类器算法完成的。该算法基于贝叶斯概率定理(你可能在数学中可能读过), 并且将元素值分配给可用类别之一中的总体。

其中, y是类变量, X是从属特征向量(大小ñ), 其中:

朴素贝叶斯分类器算法用法的一个示例是电子邮件垃圾邮件过滤。 Gmail使用此算法将电子邮件分类为垃圾邮件或非垃圾邮件。

2. K均值聚类算法–

假设你要在Wikipedia上搜索"日期"一词。现在, "日期"可以指代水果, 特定的一天, 甚至是与你的爱人浪漫的夜晚!!!因此, 维基百科使用K均值聚类算法将讨论相同想法的网页分组(因为它是用于聚类分析的流行算法)。

K均值聚类算法通常使用K个聚类对给定数据集进行操作。以这种方式, 输出包含K个群集, 其中输入数据在群集之间进行了分区(因为对具有不同"日期"含义的页面进行了分区)。

3.支持向量机算法–

支持向量机算法用于分类或回归问题。在这种情况下, 通过找到将数据集分为多个类别的特定线(超平面), 将数据分为不同类别。支持向量机算法试图找到使类之间距离最大化的超平面(称为裕度最大化), 因为这会增加更准确地对数据进行分类的可能性。

支持向量机算法用法的一个示例是用于比较同一部门中股票的股票表现。这有助于管理金融机构的投资决策。

4.先验算法–

Apriori算法使用IF_THEN格式生成关联规则。这意味着如果发生事件A, 则事件B也以一定概率发生。例如:如果某人购买汽车, 那么他们还将购买汽车保险。 Apriori算法通过观察购买汽车后购买汽车保险的人数来生成此关联规则。

Google自动完成功能是Apriori算法用法的一个示例。在Google中键入单词时, Apriori算法会查找通常在该单词之后键入的关联单词并显示可能性。

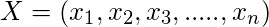

5.线性回归算法–

线性回归算法显示了自变量和因变量之间的关系。它演示了以任何方式更改自变量时对因变量的影响。因此, 自变量称为解释变量, 因变量称为关注因子。

线性回归算法用法的一个示例是用于保险领域的风险评估。线性回归分析可用于查找多个年龄客户的索赔数量, 然后推断出客户年龄增加的风险增加。

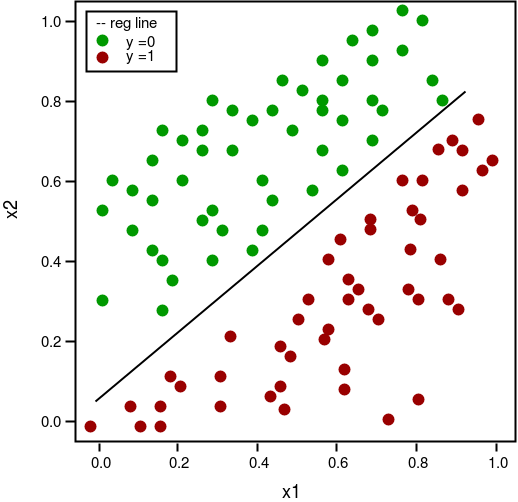

6. Logistic回归算法–

Logistic回归算法处理离散值, 而线性回归算法处理连续值的预测。因此, 逻辑回归适用于二进制分类, 其中如果发生事件, 则将其分类为1;如果未发生, 则将其分类为0。因此, 将基于给定的预测变量来预测特定事件发生的概率。

逻辑上使用Logistic回归算法的一个例子是在政治中预测某个候选人是否会赢得政治选举。

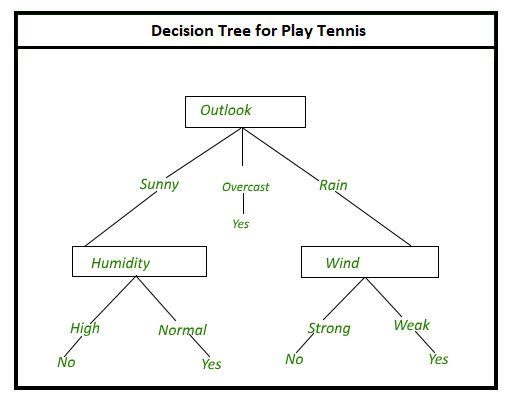

7.决策树算法–

假设你想确定生日的地点。因此, 有许多问题会影响你的决定, 例如"这家餐厅是意大利人吗?", "这家餐厅有现场音乐表演吗?", "这家餐厅是否在你家附近?"等等。每个问题的答案都是"是"或"否", 这有助于你做出决定。

这基本上是在决策树算法中发生的事情。在这里, 使用树分支方法显示了决策的所有可能结果。内部节点是对各种属性的测试, 树的分支是测试的结果, 叶节点是在计算所有属性后做出的决策。

决策树算法用法的一个示例是在银行业中, 通过按其未清偿所述贷款付款的概率对贷款申请人进行分类。

8.随机森林算法–

随机森林算法解决了决策树算法的一些局限性, 即, 当树中的决策数量增加时, 结果的准确性就会降低。

因此, 在随机森林算法中, 存在代表各种统计概率的多个决策树。所有这些树都映射到称为CART模型的单个树。 (分类树和回归树)。最后, 通过轮询所有决策树的结果来获得对随机森林算法的最终预测。

在汽车工业中, 随机森林算法用法的一个示例是预测任何特定汽车部件的未来故障。

9. K最近邻居算法–

K最近邻算法基于类似的度量(例如距离函数)将数据点分为不同的类别。然后, 通过在整个数据集中搜索K个最相似的实例(邻居)并汇总这K个实例的输出变量, 对新的数据点进行预测。对于回归问题, 这可能是结果的平均值, 对于分类问题, 这可能是模式(最常见的课堂)。

K最近邻居算法可能需要大量内存或空间来存储所有数据, 但仅在需要预测时及时执行计算(或学习)。

10.人工神经网络算法–

人脑包含神经元, 这是我们保持力和机智的基础(至少对我们中的某些人而言!), 因此, 人工神经网络尝试通过创建相互连接的节点来复制人脑中的神经元。这些神经元通过另一个神经元接收信息, 根据需要执行各种操作, 然后将信息作为输出传递到另一个神经元。

人工神经网络的一个例子是人脸识别。可以识别带有人脸的图像并将其与"非面部"图像区分开。但是, 这可能要花费多个小时, 具体取决于数据库中的图像数量, 而人脑可以立即执行此操作。

![从字法上最小长度N的排列,使得对于正好为K个索引,a[i] a[i]+1](https://www.lsbin.com/wp-content/themes/begin%20lts/img/loading.png)